一款好的拍照手机,应当具备哪些特征?

是超多的摄像头、超高的像素等级、还是强有力的ISP以及先进的算法,亦或是出色的防抖结构和用料靠谱的光学镜头?

平心而论,大多数消费者在看到这个问题的时候,首先可能会回答“多摄像头”与“高像素”,因为这是最容易从手机的外观和配置表上就能感受到的“高端细节”。而纵观整个手机市场,那些既有超高像素主摄,又有超多摄像头(大于等于四个)的机型,也的确大都具备着一线的实际成像品质。

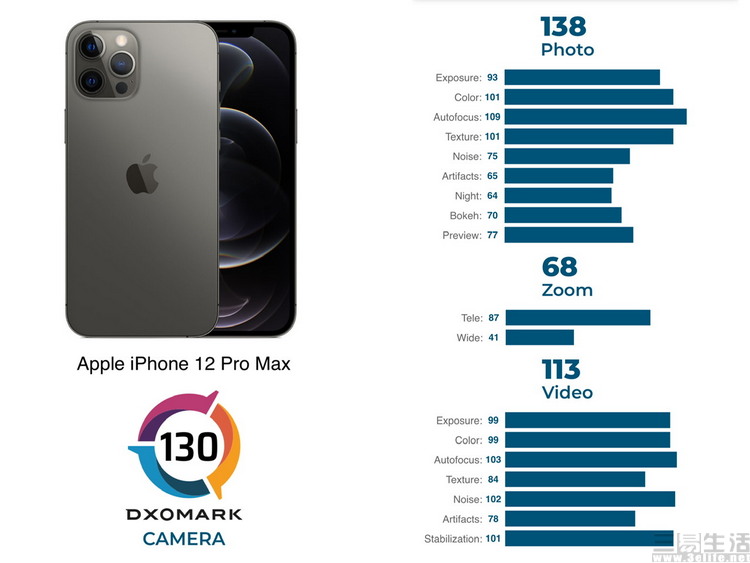

然而同样是在当前的手机行业中,有那么一家科技,至今依旧坚持2-3摄像头的后置摄像头模组设计,甚至从未使用过超过1200万像素的摄像头。但与此同时,他们的产品却每年都能名列DXOMARK拍照榜单的前几名,同时全球销量更是令同价位的竞争对手望尘莫及。

没错,我们说的正是苹果以及他们家的iPhone。那么问题就来了,不堆摄像头数量、不追求高像素,iPhone到底又是怎样做好拍照功能的呢?

首先,其实苹果很舍得硬件“堆料”

不可否认,iPhone从来没使用过“超多摄”方案,更没有配备过超高像素的CMOS,但是这绝不意味着苹果在iPhone的相机硬件上就有所吝啬。事实上其从前几年开始,就一直很舍得给iPhone的相机“堆料”,只不过许多朋友可能并没有注意到罢了。

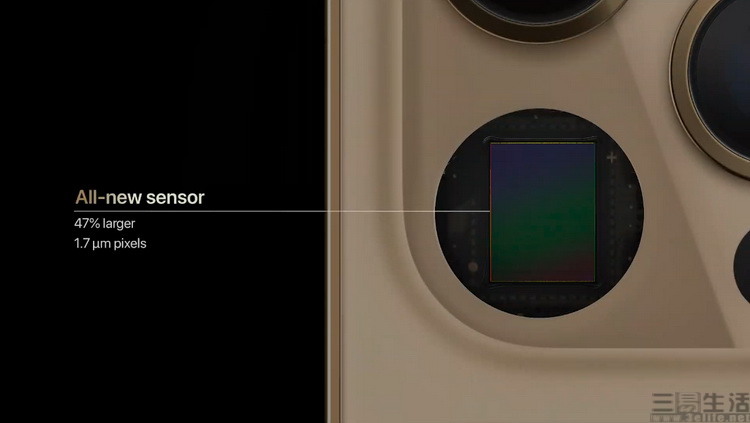

比如说论CMOS规格,苹果在iPhone 12 Pro Max上使用了一颗1/1.7英寸超大底的定制1200万像素传感器。这是什么概念呢?大家要知道,当前业界流行的6400万超高像素方案,传感器尺寸也是1/1.7英寸。但它的像素值比iPhone所用的高了五倍还多,换句话说,就是iPhone 12 Pro Max的主摄,单个像素的感光面积就是这类机型的5倍。

iPhone 12 Pro拍摄的微距照片

比如说,论对焦技术,苹果从iPhone X开始就一直坚持在主摄上配备全像素双核对焦结构。这种对焦结构的最大优点,在于它让CMOS上所有的像素点都可以作为对焦点使用,因此手机可以在整个取景面积内对任意一点进行超快速的对焦,甚至还能对运动中的物体进行自动追焦。

而相比之下,即便是当前最新一代的1.08亿像素主摄,也仅有传感器上的一部分面积可以用于对焦(相位对焦点对焦)。这就意味着,那些超高像素机型反而做不到iPhone那么快的对焦速度,更做不到仅用主摄进行超近距离的微距特写摄影。而这实际上也解释了,为什么这些机型要配备额外的独立微距镜头的原因。

除此之外,在图像防抖结构方面,苹果也有自己的想法。要知道,当前高端智能手机大多配备的都是镜头式光学防抖,也就是在镜片组里设置一块可以浮动的“防抖镜片”,用于抵消外部振动的影响。但是镜头防抖本身有着会造成光路偏斜,会带来照片边缘画质下降的明显缺点。而苹果则是业界最早一批意识到这个缺点的厂商之一,为此他们在iPhone 12 Pro Max上首次运用了新的“CMOS防抖”设计。通过将主动防抖的部件从镜片改为传感器本身,使得整个拍摄过程中,镜组内部的光路可以始终保持笔直,这样一来不仅可以实现更大的防抖范围,同时画质也自然得以更进一步。

当然,说到iPhone在相机方面的“堆料”,其实还不止上面这些。诸如现在的iPhon 12 Pro全系都有配备,可以在全黑环境下辅助对焦和人像虚化的Lidar激光雷达,诸如苹果已经用了很长很长时间的全系蓝宝石玻璃镜片,其实无论是从设备成本,还是从技术难度上来说,这些“堆料”实际上都远比其他厂商多采购几枚摄像头模组要高精尖得多。

其次,iPhone的算法既多,而且也很复杂

2017年9月12日,伴随着iPhone X的发布,苹果正式推出了自家的新一代A11仿生芯片。而它之所以被叫做“仿生(Bionic)”,是因为在这款芯片内部,苹果首次集成了自研的Neural Engine神经网络加速器模块,在它与新型ISP的合力作用下,iPhone X率先在业界实现了光照环境侦测等先进拍照算法。当时间来到2020年,尽管苹果并没有大为宣扬,但从各类相关技术材料来看,如今iPhone 12系列在拍照算法上的先进与复杂程度,更是早已今非昔比。

举例而言,当光线条件极佳或是大逆光环境时,iPhone 12系列会自动选择新的智能HDR3算法进行成像。不同于其他机型HDR算法仅仅是单纯的“多帧合成”,智能HDR3算法会先对整个场景的光线条件进行识别,按照不同的亮度、不同的被摄物类型进行分割。然后再针对不同分割元素,进行级别不同的HDR多帧合成处理,最后再将它们重新组合为一张图片。

如此一来,iPhone 12系列就可以针对性地对画面中过亮或过暗的部分叠加更多的合成帧数,而针对本来就亮度适中且细节清晰的画面元素则减少处理。最终的结果不仅可以大幅提高画面动态范围,同时也让细节画质得到了更多的保留。

而当光照条件中等的时候,iPhone 12系列则会使用苹果招牌的“深度合成”图像算法。它的原理是在使用者按下快门前,手机就已经预先拍摄数张曝光程度不同的图像,然后对它们进行像素级别的合成、修补,最终得到细节更多、解析力更强的照片。在此前的iPhone 11系列上,由于受到CMOS感光能力与芯片AI算力的制约,深度合成算法不能作用于全部的摄像头,但这一点在iPhone 12系列上已经成为过去时。如今,全部的摄像头均可使用深度合成算法,并得到更好的细节画质。

当然,如果光照条件变得更差,此时就轮到新的夜间模式出场了。与其他机型相比,iPhone 12系列这次一方面大幅强化了夜景模式的效果,并同样具备自动侦测脚架的机能,而另一方面,iPhone 12 Pro系列内置的激光雷达,在夜景模式下也扮演了关键的形状侦测和对象测距机能。有了它们的助力,iPhone 12 Pro系列不仅可以在夜间对焦更快更准,更重要的是它甚至可以主动识别出夜间被摄对象的立体脸型数据,从而实现效果惊人的夜景+人像虚化拍摄效果,也使得其在夜间拍摄上树立了一个新的标杆。

当然,苹果还更懂得“拍照手机该怎么用”

众所周知,消费者都很喜欢“拍照好”的手机,但真正要说到在手机上拍摄了照片之后用来做什么,可能其实绝大多数朋友都是没有想过的。

这意味着什么?简单来说,就是很多消费者其实并不能看出自己的手机拍照是不是真的好,他们可能喜欢浓艳的色彩,却无法分辨这到底是因为手机的拍摄逻辑本就如此,还是单纯因为手机屏幕太差,而导致回放的时候出现了偏色。他们也可能追求超长的变焦能力,却没有想过它到底有多高的实用性,在日常影像创作中是否真的具备堪用的画面素质。

但是,苹果很显然是有思考过这个问题的。因为他们卖的不只是iPhone,还有与之配套的MacBook、iPad、Apple Watch,他们知道很多摄影师会喜欢iPhone的照片色彩风格,因为它不偏不倚,没有刻意的美化,而是能够准确地还原当时拍摄的环境。他们也知道一些专业导演、职业vloger会使用iPhone作为自己的创作工具,所以iPhone不仅要屏幕色彩准确,而且也要提供足够专业的图片和视频存储选项。

比如说,iPhone 12 Pro系列可以拍摄比其他手机色彩数据多4096倍,比当前的顶级Android机型还多64倍的12bit Apple ProRAW格式无损图像,为专业影像工作者提供了非常大的后期处理空间。又比如说,iPhone 12 Pro系列也是业界首个实现杜比视界HDR视频拍摄能力的智能手机产品。相比常见的HDR10与HDR10+,杜比视界视频的色彩更丰富、亮度更高、动态范围更大,同时是目前最为专业的HDR视频录制规格之一。

不仅如此,正如我们前文中所讲到的那样,苹果还为专业的创作者提供了强大的、兼容性极佳的产品生态。当你把某些Android机型拍摄的照片拷贝到电脑上观看时,它可能会因为设备之间的色彩管理存在差异,从而导致照片的颜色变得奇怪。但无论你是使用iPad Pro、MacBook Air还是Mac Pro编辑iPhone中的照片或者视频,它们的色彩都会保持与iPhone屏幕上看起来的效果一致。

这意味着什么?这代表着近年来的iPhone,在影像领域其实从不缺少高精尖的硬件配置,也从不缺少先进且持续进步的成像算法。只不过这种严肃及专业级的设计,使得它更多地受到了那些真正热爱摄影、甚至是专业创作者的理解和喜爱。而对于习惯了其他手机厂商“镜头多才是好、像素高才是棒”这样宣传攻势的普通消费者来说,不能第一时间发现iPhone在影像设计上的用心,或是还不太能体会到它种种影像功能特性所带来的好处,自然也就并不令人感到奇怪了。

【本文图片来自网络】