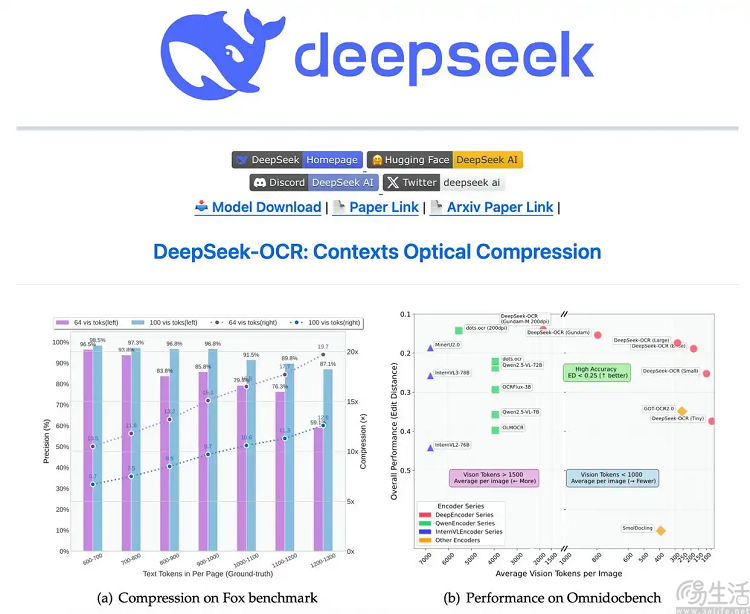

日前,DeepSeek方面发布并开源全新模型DeepSeek-OCR,并公布了该模型的相关论文《DeepSeek-OCR:Contexts Optical Compression》(《DeepSeek OCR:上下文光学压缩》)。

据了解,DeepSeek-OCR被描述为是“一项关于通过光学二维映射来压缩长上下文可行性的初步研究”,希望通过利用视觉模态作为文本信息的高效压缩介质,解决大模型处理长文本时的算力难题。换二言之,DeepSeek-OCR可以将文本压缩成视觉模态,通过“看图”来理解内容,从而消耗更少的Token。

据DeepSeek方面介绍,DeepSeek-OCR由两个核心组件组成,其中DeepEncoder(编码器)负责把图片转成高度压缩的视觉token,DeepSeek3B-MoE(解码器)负责从压缩后的视觉Token中重建文本。

为了灵活应对不同的压缩比需求和实际应用场景,DeepEncoder被训练成支持从“Tiny”(512x512, 64token)到“Gundam”(动态分块,近800token)等多种输入模式。这也就意味着同一个模型可根据任务需要,随机应变地调整其“压缩强度”。

DeepSeek3B-MoE虽然只有3B参数,但采用了MoE(混合专家)机构,64个专家中激活6个,再加2个共享专家,实际激活参数约5.7亿。因此也让模型既有30亿参数模型的表达能力,又保持了5亿参数模型的推理效率。

据DeepSeek方面透露,实测表明,当文本标记数量在视觉标记数量的10倍以内时(即压缩比<10倍),该模型可以达到97%的解码精度。在20倍的压缩比下,该模型解码精度仍能保持在约60%的水平。而在实际应用中,单张A100-40G显卡即可可支持每日20万页以上的大语言模型/视觉语言模型训练数据生成。

此外值得一提的是,在相关论文中,DeepSeek还提出了用光学压缩模拟人类遗忘机制的新思路。具体而言,鉴于人类记忆会随时间衰退,越久远的事情记得越模糊,DeepSeek方面设计将更久远的上下文渐进式地缩放成更小、更模糊的图像,以进一步减少token消耗。随着图像越来越小,内容也越来越模糊,最终达到“文本遗忘”的效果。

对此DeepSeek方面指出,这还是个需要进一步调查的早期研究方向,但对于平衡理论上无限的上下文信息或许是一个很好的方法。

【本文图片来自网络】