在近日举行的FORCE LINK AI创新巡展·武汉站相关活动中,火山引擎方面发布了升级版和新版的豆包大模型,其中包括升级豆包大模型1.6,以及新的豆包大模型1.6 lite、豆包语音合成模型2.0、豆包声音复刻模型2.0。

其中,升级后豆包大模型1.6成为国内首个原生支持“分档调节思考长度”的模型,可提供Minimal、Low、Medium、High 4种思考长度,以平衡企业在不同场景对模型效果、时延、成本的不同需求。以低思考长度为例,相比模型升级之前的单一思考模式,升级后的豆包1.6模型总输出 Tokens下降77.5%、思考时间下降84.6%,模型效果保持不变。

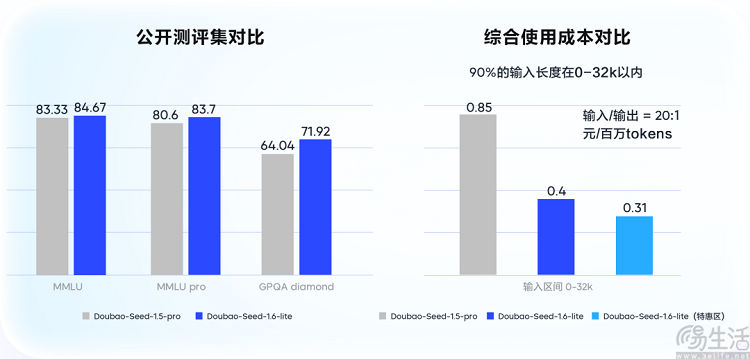

而豆包大模型1.6 lite(Doubao-Seed-1.6-lite)相比豆包大模型1.6,则更轻量、推理速度更快、更具性价比。效果上,该模型超越了豆包大模型1.5 pro(Doubao-Seed-1.5-pro),在企业级场景测评中较豆包1.5 pro提升14%。

值得一提的是,为助力企业更精细地平衡模型效果与成本,日前火山引擎方面还正式发布国内首个针对模型智能选择的解决方案“智能模型路由”(Smart Model Router)。

据了解,火山引擎“智能模型路由”支持“平衡模式”、“效果优先模式”和“成本优先模式”3种方案,可针对任务请求自动选择最合适的模型,达到效果与成本的最优解。目前火山引擎“智能模型路由”已支持豆包、DeepSeek、Qwen、Kimi 等多种主流模型。以 DeepSeek为例,经过实测,在效果优先模式、智能路由后,模型效果相比直接使用DeepSeek-V3.1提升14%;在成本优先模式、实现DeepSeek-V3.1相似效果的条件下,模型的综合成本最高下降超过70%。

此外在这次的活动中火山引擎方面透露,随着AI产业落地持续加速,截至9月底豆包大模型日均Tokens调用量已突破30万亿,相比今年5月底增长超80%。IDC发布的相关报告则显示,今年上半年中国公有云大模型服务市场中,火山引擎以49.2%的份额占比位居中国第一。

对此火山引擎CEO谭待表示,在过去4年火山引擎每年营收目标都超预期完成,今年也是如此,“我们应该更早意识到AI变化意味着什么,我们做好布局。把这件事情做好,结果就水到渠成。对我们来说,AI大幅降低企业和开发者使用的门槛”。

【本文图片来自网络】