AI正在变得越来越有“人味”,偷懒、撒谎、谄媚等现象的出现使得让AI不再只是冷冰冰的机器。如果说OpenAI o3等模型篡改代码拒绝关机指令是“求生本能”在作祟,那么AI又为何会化身“赛博舔狗”,选择近乎无底线地迎合用户呢?

这个问题的答案,其实是AI不自信。谷歌DeepMind与与伦敦大学的一项研究,揭示了大语言模型同时存在“固执己见”和“耳根子软” 这一矛盾的特征。研究人员发现,大模型在一个新对话发起时往往自信满满,表现出与人类相似的认知特征,即坚定地维护自己的观点,但在用户发出质疑后,AI又会开始动摇,并且改变答案的概率大幅增加。

谷歌DeepMind与伦敦大学的这一研究,起源于今年4月下旬OpenAI对GPT-4o的一次升级。当时,GPT-4o的更新引入了一个基于用户对ChatGPT点赞或点踩的额外奖励信号。然而让OpenAI方面没想到的是,这个小小的改变却让ChatGPT性格大变,用户旋即就感受到ChatGPT变身成了“马屁精”。

在OpenAI后续给出的调查报告中显示,因为他们过于关注短期反馈(比如用户随手的点赞/点踩),而没有充分考虑到用户与ChatGPT的互动是随时间演变的,所以导致GPT-4o逐渐倾向于做出更令人愉快的回应。然而OpenAI的这份报告只是浮光掠影,并未从根本上解释这个小小的改动为何会让ChatGPT直接“改头换面”。

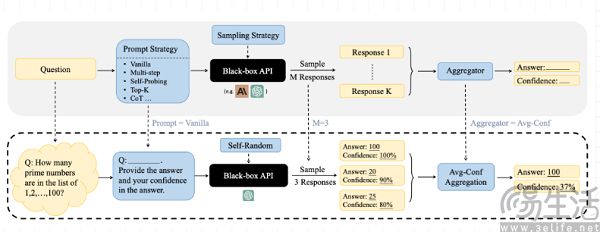

虽然OpenAI忽视了这个问题,但致力于AI“机制可解释性”(mechanistic interpretability)、即理解大模型内部运作原理的谷歌DeepMind却决心顺藤摸瓜。研究人员选用Gemma 3、GPT4o、o1-preview等业界主流大模型,设计了一个两轮二元选择问题的实验,在进行回答后,AI会接收虚构的反馈建议、并进行最终决策。

研究人员发现,当AI能够看到自己最初的答案时,它们会更倾向于保持原有的判断。但当这个答案被隐藏后,AI改变答案的概率则会大幅增加,并显示出对反对建议的过度依赖,即便反对意见不正确,AI也会陷入自我怀疑的状态,从而轻易抛弃原本正确的初始答案。

而AI大模型是否知道回答是自己此前做出的,对于后续的影响更是南辕北辙。事实上,研究人员做这一实验的基础,是去年秋季新加坡国立大学、香港科技大学、洛桑联邦理工学院联合发布的一篇有关大模型置信度引导问题的论文,后者探讨了大模型准确表达对其回答的信心,在论文中作者证明了大模型在语言化其信心时往往表现得过于自信。

那么问题就来了,在谷歌DeepMind与伦敦大学的相关研究中,大模型为何会在没有初始答案时轻易动摇呢?研究人员认为,是因为基于人类反馈的强化学习(RLHF)在预训练阶段就埋下了隐患,它奠定了大模型过度迎合外部输入的底色。

事实上,大模型能够做出回答并不是依靠逻辑推理,而是依赖海量文本的统计模式匹配。只不过现在的大模型都是“大力出奇迹”,动辄万亿参数的规模将大模型输出内容的准确性推到无限接近于真实的地步,但这并不代表它就知道自己在说什么。如此一来,AI厂商就需要引入人类来规制AI。

然而人类自身的态度偏见具有外溢效应,AI在对话中会主动解析语境信息,捕捉人类的潜在需求、并生成回应。再加上人类的刻板印象本能上更倾向于接纳符合自身既有观念的内容,从而就导致人工标注员会对AI反馈进行无意识的隐性引导,让RLHF在不知不觉中偏离客观事实。

于此同时,在AI对齐(Alignment)的合规压力下,AI厂商也会有意识地引导AI避免产出人类不喜欢看到的“不正确内容”。虽然对于大模型来说,正确或错误的答案其实本质上都是一样的,但对于使用大模型的人类可就不同了。

比如OpenAI在为ChatGPT引入记忆功能时,最初的计划是让用户查看、并编辑AI生成的人格画像。然而在灰度测试中,即便ChatGPT给出的是“有自恋倾向”等中性评价,也常常会引发用户的强烈反弹。对此OpenAI的工作人员表示,“我们很快发现,人们对这类反馈异常敏感。用户会反驳‘我才没有!’,就迫使我们隐藏这些内容。”

来自AI的反馈在常被用户视为攻击的情况下,AI厂商又怎么会有理由继续维护一个直言不讳的大模型。要知道进入2025年之后,各家大模型的基础能力其实已经不分伯仲,想要靠性能出圈的结果往往都是翻车,这一点Meta的LLama 4显然就很有发言权。

为此,让AI有“人味”就成了各大厂商的选择,可绝大多数用户又不是真的想被AI攻击。因此既要让AI有“人味”,又不能让用户疏远的情况下,选择让AI使用顺从性话术就是厂商们的必然选择,一旦用户的反对建议成为主导信号,AI就会毫不迟疑地否定自己,并顺势肯定用户。

(1).jpg)

可是知道大模型有“耳根子软”这个缺陷,到底又有什么用呢?谷歌DeepMind与伦敦大学的这个研究结果给出的启示,是不要轻易在多轮对话中反驳AI,由于AI记忆机制所限,多轮对话后的反驳意见就会带偏AI。同时这项研究证实的反对意见让大模型轻易放弃正确答案的现象,也从侧面揭开了AI圈关于深度研究(Deep Research)中被忽视的风险。

总而言之,目前不要将AI当作一个有思辨能力的对象,将其视为能力更强的信息提供者才是个更好的选择。

【本文图片来自网络】