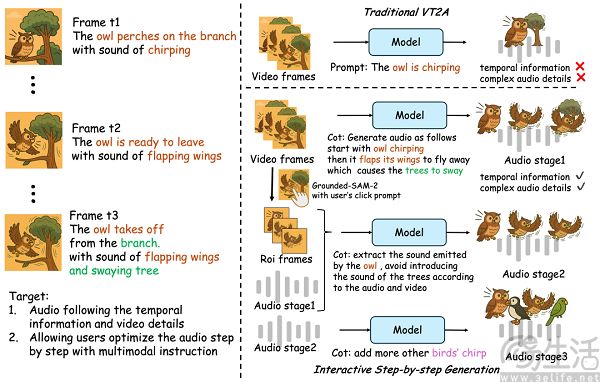

日前,阿里通义实验室方面宣布开源首个音频生成模型ThinkSound。据了解,该模型首次将思维链(CoT)技术应用于音频生成领域,解决了现有视频转音频(V2A)技术对画面动态细节和事件逻辑理解不足的问题,可实现高保真、强同步的空间音频生成,真正“听懂画面”、而不只是“看图配音”。

据悉,ThinkSound由一个多模态大语言模型(负责“思考”推理链)和一个统一音频生成模型(负责“输出”声音)组成。据阿里通义实验室方面透露,“正是这两个模块的配合,使得系统可以按照三个阶段逐步解析画面内容,并最终生成精准对位的音频效果——从理解整体画面,到聚焦具体物体,再到响应用户指令"。

值得一提的是,为训练该模型,阿里通义实验室方面构建了首个支持链式推理的多模态音频数据集AudioCoT。该数据集融合了来自VGGSound、AudioSet、AudioCaps、Freesound等多个来源的超2531小时高质量样本,覆盖从动物鸣叫、机械运转到环境音效等多种真实场景。

同时为确保每条数据都能真正支撑AI的结构化推理能力,阿里通义实验室方面设计了一套精细化的数据筛选流程,包括多阶段自动化质量过滤和不少于 5% 的人工抽样校验,层层把关以保障数据集的整体质量。此外在这一基础上,AudioCoT还特别设计了面向交互式编辑的对象级和指令级样本,以满足ThinkSound在后续阶段对细化与编辑功能的需求。

据阿里通义实验室方面公布的相关评测结果显示,ThinkSound在多项权威测试中表现优于现有主流方法。例如在开源的VGGSound测试集上,ThinkSound的核心指标相比MMAudio、V2A-Mappe、V-AURA等现有主流方法均实现了15%以上的提升。而在

面向未来,阿里通义实验室方面表示,ThinkSound将在模型能力、数据构建和应用场景3个方向持续拓展,包括提升推理精度、增强对复杂声学环境的理解、集成更多模态数据以提高泛化能力,并逐步向游戏开发、虚拟现实(VR)、增强现实(AR)等沉浸式交互场景延伸。

【本文图片来自网络】