日前,阿里云通义千问方面发布第二代视觉语言大模型Qwen2-VL。据悉,该模型可集成至智能手机、机器人等设备中,并根据视觉环境和文字指令进行自动操作。

据通义千问方面介绍,Qwen2-VL可理解20分钟以上的长视频,并将视频内容用于基于视频的问答、对话和创作等方面。例如对于一部2小时的纪录片,其可以快速检索视频内容,并从复杂的影像和解说中提取出关键信息,从而为用户提供详细准确的回答,同时该模型还能根据视频内容进行故事续写、影片撰写或是创意改编。此外,其还能理解图像视频中的多语言文本,包括中文、英文,大多数欧洲语言,以及日语、韩语、阿拉伯语、越南语等。

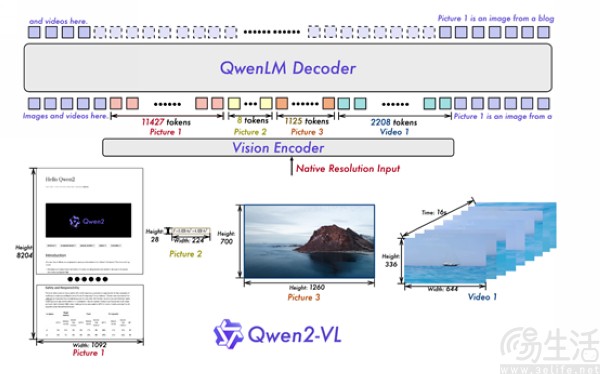

值得一提的是,Qwen2-VL较上一代的图像理解性能得到了全面提升,即实现了对原生动态分辨率的全面支持。具体而言,其能够处理任意分辨率的图片输入,并将不同大小的图片转换为动态数量的tokens、最小只占4个tokens。此外该模型在架构上另一个重要创新为多模态旋转位置嵌入(M-ROPE),使得其能够同时捕捉并整合一维文本序列、二维视觉图像,以及三维视频的位置信息。

对此通义千问方面表示,这种架构设计不仅能让模型输入与图像原始信息之间保持高度一致性,更是模拟了人类视觉感知的自然方式,使其在图像处理领域呈现出更加灵活、高效的表现。

据悉,目前Qwen2-VL模型共发布了2B、7B、72B 3个版本,其中2B和7B版本为开源模型、授权协议为Apache 2.0,这也意味着开发者可随意使用、修改或商用。同时,旗舰模型Qwen2-VL-72B的API也已上线阿里云百炼平台。

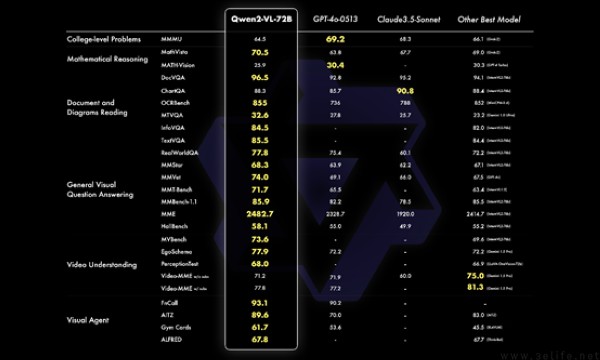

其中在性能水平方面,通义千问团队从大学题目、数学、文档表格多语言文字图像的理解、通用场景下的问答、视频理解、Agent等角度,对Qwen2-VL进行了综合测试。结果显示,该模型72B版本的大部分性能超过了GPT-4o,仅在对综合大学题目的理解上与后者有一些差距;Qwen2-VL-7B模型则与GPT-4mini水平相当,并且文档理解能力和多语言文字理解能力均与SOTA在同一水平。

【本文图片来自网络】