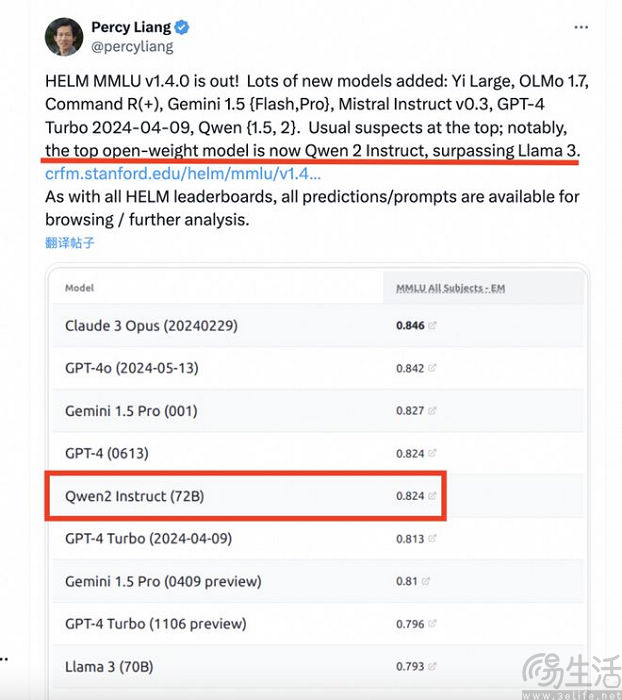

日前,斯坦福大学基础模型研究中心(CRFM)发布了大模型测评榜单HELM MMLU的最新结果。其中显示,阿里巴巴通义千问Qwen2-72B模型排名第5,仅次于Claude 3 Opus、GPT-4o、Gemini 1.5 pro、GPT-4,是排名第一的开源大模型、性能超越Llama3-70B,同时也是排名最高的中国大模型。

据悉,MMLU(Massive Multitask Language Understanding,大规模多任务语言理解)是业界最有影响力的大模型测评基准之一,涵盖基础数学、计算机科学、法律、历史等57项任务,用以测试大模型的世界知识和问题解决能力。但在现实测评中,不同参评模型的测评结果有时缺乏一致性、可比性,原因则包括使用非标准提示词技术、没有统一采用开源评价框架等。

而CRFM提出的基础模型评估框架HELM(A holistic framework for evaluating foundation models),则旨在创造一种透明、可复现的评估方法。该方法基于HELM框架,对不同模型在MMLU上的评估结果进行标准化和透明化处理,从而克服现有MMLU评估中存在的问题。

据了解,通义千问Qwen2系列模型于今年6月初开源,包含Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B,以及Qwen2-72B五个尺寸的预训练和指令微调模型,其中Qwen2-57B-A14B为混合专家模型(MoE)。而且Qwen2所有尺寸模型都使用了GQA(分组查询注意力)机制,以便让用户体验到GQA带来的推理加速和显存占用降低的优势。

据阿里方面此前公布的相关信息显示,相比通义千问Qwen1.5系列,通义千问Qwen2系列实现了整体性能的代际飞跃,代码、数学、推理、指令遵循、多语言理解等能力均有所提升。其中在多语言能力方面,Qwen2系列模型针对性地对除中英文以外的27种语言进行了增强,包括德语、法语、俄语等,同时Qwen2系列模型还针对性地优化了多语言场景中常见的语言转换(code switch)问题。

代码能力方面,Qwen2系列模型还成功融入了CodeQwen1.5的成功经验,在多种编程语言上的实现显著效果提升。而在数学能力方面,大规模且高质量的数据帮助Qwen2-72B-Instruct实现了数学解题能力的飞升。

此外在长文本处理方面,Qwen2系列中的所有Instruct模型,均在32k上下文长度上进行训练,并通过YARN或Dual Chunk Attention等技术扩展至更长的上下文长度,其中Qwen2-72B-Instruct能够完美处理128k上下文长度内的信息抽取任务。对此阿里方面曾表示,“只要有充足的算力,它一定能成为你处理长文本任务的首选”。

需要注意的是,Qwen2系列模型采用了不同的模型许可。据了解,除了Qwen2-72B依旧使用此前的Qianwen License外,其余模型,包括Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B以及Qwen2-57B-A14B在内,均采用Apache 2.0的许可。

面向未来,阿里巴巴方面此前透露,“我们还在训练更大的模型,继续探索模型及数据的Scaling Law。此外,我们还将把Qwen2扩展成多模态模型,融入视觉及语音的理解。在不久的将来,我们还会继续开源新模型”。

【本文图片来自网络】