要提到Mac最大的槽点,可能就非“祖传”的8GB内存莫属了。日前,一位名为David Schaub的网友社交平台发布了一篇分析文章,揭示了苹果公司自蒂姆·库克掌舵之后停止Mac内存升级周期的事实。此前在乔布斯时代,苹果基本每两年就会将Mac机型的起步内存进行升级,然而在库克接管后,仅仅在2017年将MacBook Air的标配内存升级到了8GB。

没错,Mac系列机型已经已经足足有7年时间没有提升过内存的起步配置了。对此苹果方面声称,Mac使用的8GB统一内存(Unified Memory)与竞争对手的16GB内存(Memory)相当,官方给出的答复是8GB内存足以驾驭上网、播放视频、轻量编辑等很多任务。然而令人玩味的是,苹果Mac产品营销部门Laura Metz却在接受相关采访时表示,“Mac是用户可以买到的最好的操作生成式AI的个人电脑产品。”

自2024年AI PC逐渐成为个人电脑领域的时髦词汇之后,苹果方面就一直在渲染Mac是消费者可以买到的最好AI PC。按照Laura Metz的说法,从2020年第一款M系列芯片M1推出时,苹果就已经开始AI的部署,M1芯片上出现的神经网络引擎就是为AI而生。

那么问题就来了,8GB起步的内存与Mac是最好的AI PC难道不冲突马?如今你打开抖音、B站、小红书等社交平台会看到,不少网友在咨询如何配置一台畅玩AI的电脑,尽管其他人给出的配置单或许各有不同,但32GB起步的内存却几乎都是一样的。

其实不仅仅是爱好者持有这样的看法,Intel方面在不久前举行的2024中国闪存市场峰会上也表示,未来AI PC入门级标配一定是32GB内存,当前常规的16GB内存会被淘汰。

运行AI大模型需要大容量的显存是众所周知的事情,英伟达的RTX 4090显卡为何卖得火爆,就是因为它拥有24GB的超大容量显存。RTX 4090在国内市场禁售后,RTX 2080Ti这款老显卡又重新走红,就是因为它可以通过魔改的方式将显存从11GB扩展到22GB。

那么为什么显存会如此重要呢?这是因为“内存墙”的存在,使得“CUDA out of memory”这样的报错提示几乎成为了所有AI从业者的噩梦。而CUDA out of memory是指使用CUDA进行计算时,GPU内存不足所导致的错误,它往往出现在需要处理大量数据时,这也是为什么在购买用于AI的GPU时,显存是最为核心的指标之一。

伯克利大学的研究团队就发现,未来内存墙可能将会是比算力更大的瓶颈,GPU的显存容量严重制约了可训练的模型规模和算力提升速度,或将成为阻碍AI技术发展与落地的重要瓶颈。

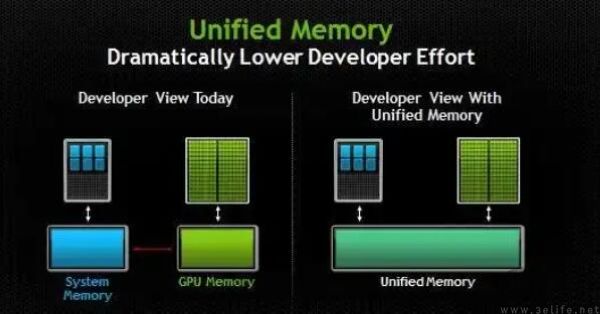

GPU的显存如果只有8GB水平,无论开发者如何进行优化,想要容纳一个千亿参数的大模型也只能是巧妇难为无米之炊。而苹果的统一内存架构是其在AI赛道上最强的一张牌,而统一内存就是把内存、GPU的显存,以及CPU的缓存放到一起,通过Fabric和CPU/GPU/神经网络处理器相连,带来了高速内存访问、高效的多任务处理、更高的图形处理能力以及更强的能耗表现。

将内存直接作为显存使用,这就是苹果统一内存的优势。但问题在于,统一内存即便再有魔力,苹果也不可能做到让所有的统一内存都去作为显存使用,维持系统基本的性能开销也需要一定的内存。根据相关开发者的实测,64GB内存的Mac能够分配给显存的部分是36GB,即64GB内存的Mac是不可以直接运行65B参数的大模型。由此不难发现,8GB内存的Mac可以使用的大模型就极为有限了。

以6B这样一个端侧大模型的典型参数规模为例,把模型参数加载到显存在不同条件下其实是不一样的,用FP32精度需要24GB,用FP16精度需要12GB,用INT8/FP8精度需要6GB,用INT4精度需要3GB。但问题是低位量化对大模型的整体表现是不利的,还会带来准确度的牺牲。所以现在相当多的大模型厂商宁愿直接做小尺寸模型,也不准备将大尺寸模型蒸馏到小尺寸。

如此一来,8GB内存的Mac想要部署端侧大模型,就成为了一个极具挑战性的操作。可是如果没有端侧大模型,Mac还能被称为AI PC吗?

【本文图片来自网络】