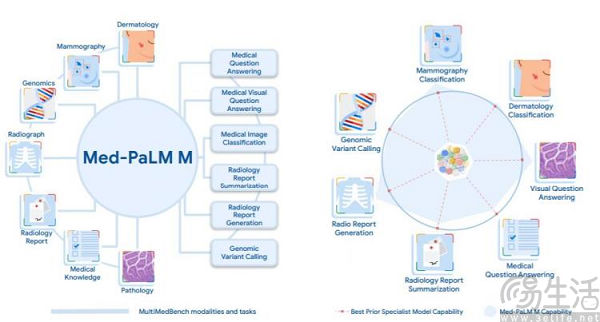

近日,谷歌Research和DeepMind团队共同发表论文《Towards Generalist Biomedical AI》,公布了一款名为Med-PaLM M(Med-PaLM Multimodal)的多模态生成模型。据了解,相较于谷歌方面此前发布的Med-PaLM、Med-PaLM-2等医疗大模型,Med-PaLM M可处理多模态生物医学数据,包括临床数据语言、影像和基因组。

对此谷歌方面表示,Med-PaLM M是通用生物医学人工智能系统的首次尝试,“是通用医学人工智能史上的一个里程碑”。

据悉,Med-PaLM M的基本架构是PaLM-E(多模态语言模型),并采用ViT预训练模型作为视觉编码器,具体实现了三种组合,分别为PaLM 8B+ViT 4B(PaLM-E 12B)、PaLM 62B+ViT 22B(PaLM-E 84B)、PaLM 540B+ViT 22B(PaLM-E 562B)。

在性能评估阶段,谷歌方面主要测试了Med-PaLM M的“多面手”(即全科)能力、突发涌现能力,以及放射学报告生成质量(与真实放射科医生进行对比)。

测试结果显示,与专业SOTA模型和无生物医学领域微调的广义模型(PaLM-E 84B)相比,Med-PaLM M在MultiMedBench上的所有任务、数据集和指标组合(共14项)中,性能均基本接近SOTA或超过SOTA。但需要注意的是,该结果是在没有任何特定任务定制的情况下使用相同模型权重集实现的。

而在scale实验中,三个不同规模的Med-PaLM M对各类任务的影响各不相同。粗略来看,对于纯语言任务和需要调整的多模式任务来说,模型越大越好;但对图像分类和胸部X光报告生成任务来说,84B的效果比562B表现反而更好一些。在放射性报告生成测试中,84B参数的Med-PaLM M平均有40.50%的报告比放射科医生做的更好(被临床医生采纳),而12B和562B参数的Med-PaLM M这一数据则分别为34.05%和32.00%。

【本文图片来自网络】